Per parlare di Ai bisogna rispondere alla domanda: che cos’è l’uomo?

Per gentile concessione dell’autore, pubblichiamo il testo, rivisto e ampliato, dell’intervento di Alberto Chierici, ricercatore in Ai, industry e government advisor, all’incontro “Il progresso tecnologico: il rischio di un cuore artificiale” tenutosi lo scorso 23 aprile al Centro internazionale di Comunione e liberazione a Roma.

Il progresso e la dottrina sociale della Chiesa

Il titolo del nostro incontro di oggi è “Il progresso tecnologico: il rischio di un cuore artificiale”. Spesso mi interrogo: il cosiddetto “progresso tecnologico” che abbiamo sperimentato, è realmente un progresso? Ci ha realmente portato avanti, in uno stato migliore di prima? Per esemplificare con un’analogia semplice: sono una persona piuttosto nostalgica e mi capita spesso di guardare film degli anni Novanta, epoca in cui si usava ancora il telefono a filo. Ricordo quanto fosse semplice allora organizzare un incontro con 10-15 amici attraverso le catene telefoniche.

Oggi, l’uso di WhatsApp mi provoca ansia solo al pensiero di dover organizzare un appuntamento. Non esiste una responsabilità chiara, non c’è un modo di comunicare che tutti conoscano e rispettino. Ci troviamo in una giungla di opinioni, amicizie compromesse, la tirannia degli ultimi momenti. Quindi, mi chiedo, questa digitalizzazione delle relazioni sociali ha realmente creato un sistema di comunicazione migliore rispetto a quello del passato? O siamo piuttosto di fronte a una complicazione delle dinamiche umane?

Confrontandomi quindi sul significato del progresso, sono tornato spesso negli anni, anche prima dell’avvento di ChatGPT, a riflettere su questo tema. Alcuni anni fa ho scritto un piccolo libro sull’etica dell’intelligenza artificiale, un modo per dialogare con i miei colleghi che lavorano nel campo della data science e sviluppano questi sistemi. Era un pretesto per avviare discussioni che normalmente non vengono affrontate. Ho consultato spesso alcuni testi della dottrina sociale della Chiesa, confrontandomi con le varie indicazioni su cosa significhi un progresso veramente umano, un progresso che riguarda la persona nella sua totalità e non solo un aspetto limitato della realtà. In particolare, nella Populorum Progressio, l’enciclica sociale del 1967, si legge:

“Essere affrancati dalla miseria, garantire in maniera più sicura la propria sussistenza, la salute, una occupazione stabile; una partecipazione più piena alle responsabilità, al di fuori da ogni oppressione, al riparo da situazioni che offendono la loro dignità di uomini; godere di una maggiore istruzione; in una parola, fare conoscere e avere di più, per essere di più: ecco l’aspirazione degli uomini di oggi, mentre un gran numero d’essi è condannato a vivere in condizioni che rendono illusorio tale legittimo desiderio”.

Il desiderio di “essere di più”

Riflettendo sugli sviluppi dell’intelligenza artificiale, spesso emerge la promessa che queste tecnologie porteranno a scoperte scientifiche, aumenteranno la nostra conoscenza e, in definitiva, estenderanno la nostra umanità. Perché c’è questo desiderio di “essere di più”? L’essere umano è un entità particolare, un “animale strano” che possiede una capacità di trascendenza, un essere che aspira a superare i propri limiti. Tuttavia, come osserva Paolo VI negli anni ’60, un grande numero di persone è costretto a vivere in condizioni che rendono questo legittimo desiderio un’illusione. Penso che, fino ad oggi, non ci siamo mossi molto da quella situazione. Leggiamo in Caritas In Veritate, l’enciclica sociale di Benedetto XVI del 2009:

“Il problema dello sviluppo oggi è strettamente congiunto con il progresso tecnologico […] La tecnica — è bene sottolinearlo — è un fatto profondamente umano, legato all’autonomia e alla libertà dell’uomo. Nella tecnica si esprime e si conferma la signoria dello spirito sulla materia. […] La tecnica permette di dominare la materia, di ridurre i rischi, di risparmiare fatica, di migliorare le condizioni di vita. […]”.

La promessa della tecnologia è vasta, e per comprendere il suo impatto anche nella mia esperienza professionale, mi sono chiesto se l’intelligenza artificiale abbia realmente avuto successo. Un esempio significativo si trova nell’automazione industriale, in particolare nella robotica industriale. Pensiamo ai robot meccanici o ai vari trolley meccanici utilizzati nei magazzini, che impiegano forme di intelligenza artificiale per il “planning”, ovvero la pianificazione della prossima azione in uno spazio fisico. Questi strumenti hanno ottenuto un enorme successo e hanno trasformato diverse industrie. Il loro funzionamento è reso possibile dalla definizione di ciò che viene chiamato “involucro robotico.”

Dall’involucro robotico all’involucro culturale: dove (e come) l’intelligenza artificiale ha successo

L'”involucro robotico” si riferisce a quella realtà tridimensionale definita e delineata che stabilisce il raggio d’azione e le condizioni di sicurezza per il funzionamento efficace di una macchina. Ad esempio, un robot meccanico progettato per verniciare automobili su una linea di produzione opera all’interno di uno spazio tridimensionale appositamente predisposto. Questo permette al robot di svolgere le sue attività con un alto grado di successo. Se lo stesso robot fosse posizionato in un ambiente non adatto, come la mia cucina casalinga, il suo funzionamento sarebbe inefficace perché mancherebbe l’involucro robotico adatto: l’ambiente circostante non è configurato per supportarne le operazioni. Analogamente, nell’ambito dell’intelligenza artificiale si parla di “involucro digitale”, che, a differenza dell’involucro robotico, non è fisico.

Il caso dei sistemi di pilota automatico

Per illustrare il concetto di involucro digitale, è utile considerare i sistemi di pilota automatico, che rappresentano una via di mezzo tra sistemi robotici e digitali. Durante il mio lavoro in Tesla, mi occupavo degli algoritmi per un prodotto che doveva calcolare il rischio di incidenti, anche quando era attivato l’autopilota. Ironia della sorte, un giorno, mentre guidavo con l’autopilota attivo, la macchina ha frenato bruscamente e un veicolo mi ha tamponato. Secondo il codice stradale vigente, la colpa è stata attribuita al pilota dietro di me, perché non manteneva la distanza di sicurezza. Tuttavia, dentro di me si è accesa una riflessione: sì, per la legge la colpa è sua, ma a decidere di frenare è stato un algoritmo, e quella decisione era errata. Non avrei frenato in quelle circostanze.

Strade e intelligenza artificiale

Tesla, come molte altre aziende americane, ha un sistema che spesso permette loro di evitare responsabilità legali per incidenti di questo tipo. Questo porta alla questione dell’involucro digitale rispetto a quello fisico. L’errore si è verificato perché l’algoritmo dell’autopilota, a differenza di un essere umano, non riesce a prendere decisioni nuanciate; deve scegliere in modo binario, 1 o 0. Le telecamere dell’autopilota avevano rilevato un veicolo nella mia corsia, ma in realtà c’era solo una ruota del veicolo davanti a me che sporgeva nella mia corsia. Io, guidando, avevo tutto lo spazio necessario per continuare senza frenare, mentre l’autopilota ha categorizzato la presenza del veicolo come un ostacolo imminente e ha deciso di frenare. In quel caso, l’involucro fisico non è predisposto per compiere una decisione corretta, e quello digitale, tantomeno la rappresentazione digitale della realtà fisica che l’Ai ricostruisce (l’involucro digitale).

Questi errori di interpretazione sono anche legati a come sono dipinte le corsie sulle strade: se mal dipinte o assenti, o in situazioni di lavori in corso con corsie provvisorie, l’intelligenza artificiale può fallire. Questo perché non esiste un “involucro robotico” ben definito, ovvero l’ambiente operativo non è ottimizzato per garantire il successo della macchina. Le strade sono disegnate perché gli esseri umani operino al meglio, non per i robot o per le intelligenze artificiali.

La nostra vita, i social e l’involucro digitalizzato

Nel campo digitale, consideriamo i social media. Con piattaforme come Facebook o Instagram, abbiamo trasformato i nostri rapporti sociali, la condivisione di immagini e opinioni in un involucro digitale, digitalizzando completamente queste interazioni. Abbiamo creato un ambiente virtuale in cui l’intelligenza artificiale può ottenere un grande successo grazie all’accesso a un’enorme quantità di dati. Questi algoritmi funzionano bene ottimizzando determinate metriche, come il tempo che trascorriamo sulle piattaforme, piuttosto che informarci accuratamente sugli eventi. L’obiettivo è massimizzare i ricavi per le aziende come Meta, ottimizzando il tempo che la nostra attenzione rimane catturata sulla piattaforma, aumentando così le possibilità che gli inserzionisti possano vendere pubblicità o prodotti.

Questa situazione solleva questioni importanti su quali aspetti della nostra vita siamo disposti a trasformare in un involucro digitalizzato e in che misura siamo disposti a meccanizzare e robotizzare le nostre realtà per favorire il successo dell’automazione. Leggiamo nell’enciclica sociale di Papa Francesco, Fratelli Tutti, del 2020, cosa dice dei social media:

“Nella comunicazione digitale si vuole mostrare tutto ed ogni individuo diventa oggetto di sguardi che frugano, denudano e divulgano, spesso in maniera anonima. Il rispetto verso l’altro si sgretola e in tal modo, nello stesso tempo in cui lo sposto, lo ignoro e lo tengo a distanza, senza alcun pudore posso invadere la sua vita fino all’estremo”.

Il motivo del successo dell’intelligenza artificiale

Durante una recente lezione in un corso di giornalismo, ho tentato di spiegare ai partecipanti cosa sia ChatGPT, come funzioni e quale impatto possa avere sulla professione giornalistica. Una domanda di uno studente ha sollevato un punto molto pertinente: spesso, per comprendere l’entità del progresso e il ruolo dell’intelligenza artificiale nel modellare il futuro, si ricorre a esempi come la fissione nucleare o l’invenzione della stampa, che hanno indubbiamente trasformato il mondo. Tuttavia, non è mai una singola tecnologia a cambiare tutto isolatamente, ma piuttosto un contesto culturale, storico e sociale che circonda queste tecnologie. E la domanda era: qual è oggi il contesto culturale che potrebbe permettere cha l’Ai diventi una tecnologia responsabile di un cambiamento epocale?

Riflettendo su quanto discusso riguardo all’involucro robotico e quello digitale, possiamo estendere il concetto a un “involucro culturale” che permette a una tecnologia non solo di avere successo, ma anche di essere accettata e integrata nella società ormai predisposta per poterla far funzionare al suo meglio. Questo studente chiedeva dunque quale sia l’involucro culturale attuale che facilita il successo di questi sistemi. Le risposte a questa domanda sono cruciali per comprendere come le tecnologie emergenti, come l’intelligenza artificiale, possano essere orientate e modellate per un impatto positivo o negativo nella nostra società.

Il motivo del successo delle intelligenze artificiali, che catturano tanta attenzione, investimenti e risorse, è complesso e sfaccettato. Non ho una risposta definitiva alla domanda di quello studente, ma è un punto su cui ho cominciato a riflettere a lungo nel tentativo di comprendere meglio la direzione in cui si stanno muovendo queste tecnologie.

Il problema antropologico

Una concezione sottostante nello sviluppo delle Ai è che, se l’essere umano è riducibile a ciò che accade nel nostro cervello, allora dovrebbe essere possibile replicarlo. Il cervello viene visto come una macchina, un insieme di ingranaggi, che, con un modello adeguato, potrebbe essere perfettamente mimato grazie all’avanzamento della conoscenza, alla disponibilità di più dati e a una maggiore potenza computazionale.

Questa concezione culturale preoccupa molto. Se l’uomo viene considerato alla stregua di una macchina, nulla ci impedisce di trattarlo come tale. Qual è allora la dignità dell’essere umano in un contesto dove si sviluppano prodotti che sfruttano l’umanità stessa, come gli algoritmi dei social media? Questa è una questione fondamentale che dobbiamo affrontare per comprendere non solo le capacità delle tecnologie emergenti, ma anche i loro limiti etici e il loro impatto sulla società. Ancora in Caritas in Veritate, leggiamo:

“Lo sviluppo tecnologico può indurre l’idea dell’autosufficienza della tecnica stessa quando l’uomo, interrogandosi solo sul come, non considera i tanti perché dai quali è spinto ad agire. È per questo che la tecnica assume un volto ambiguo. Nata dalla creatività umana quale strumento della libertà della persona, essa può essere intesa come elemento di libertà assoluta, quella libertà che vuole prescindere dai limiti che le cose portano in sé. […] noi tutti conosceremmo, valuteremmo e decideremmo le situazioni della nostra vita dall’interno di un orizzonte culturale tecnocratico, a cui apparterremmo strutturalmente, senza mai poter trovare un senso che non sia da noi prodotto. Questa visione rende oggi così forte la mentalità tecnicistica da far coincidere il vero con il fattibile”.

Il punto sollevato è molto rilevante, riflettendo su quanto l’ingegnerizzazione eccessiva di ogni aspetto della società e del lavoro possa distogliere l’attenzione dal “perché” si fanno le cose o si scelgono certi processi piuttosto che altri. Questo approccio può portare a numerosi problemi sociali.

La sorpresa della scoperta di ChatGPT

Questo mi fa anche riflettere sulla scoperta di ChatGPT. La sorpresa non è stata tanto nelle sue capacità operative, cioè nel fatto che riesca ad adempiere a un grande numero di compiti diversi, ma quanto nel constatare che basta “predire la prossima parola” per gestire compiti che una volta richiedevano metodologie completamente diverse. Un tempo, ad esempio, la traduzione automatica o la stesura di programma informatico erano considerate discipline separate e complesse, studiate con diverse tecniche e modelli di Ai. La sorpresa sta nel realizzare che un unico approccio può abbracciare tutte queste funzioni.

Il positivismo tecnologico

È un peccato, per esempio, che non ci sia un interesse scientifico maggiore nel comprendere il “perché” funziona in questo modo. Troppo spesso si salta la fase di comprensione profonda della realtà e si passa direttamente all’utilizzo pratico di una tecnologia perché “funziona” (più o meno!). Ciò riflette un positivismo tecnologico inesorabile: se una tecnologia funziona e produce profitto, allora deve essere adottata. Questo approccio rischia di trascurare riflessioni più profonde sulle implicazioni etiche e sociali delle tecnologie che adottiamo, come ben sottolineato in Caritas in Veritate. Benedetto XVI scriveva:

“Ma quando l’unico criterio della verità è l’efficienza e l’utilità, lo sviluppo viene automaticamente negato. Infatti, il vero sviluppo non consiste primariamente nel fare”.

L’ingegnerizzazione eccessiva e la trascuratezza scientifica nello sviluppo delle intelligenze artificiali rischiano di non portare un vero progresso, anche da un punto di vista conoscitivo. Infatti,

“Chiave dello sviluppo è un’intelligenza in grado di pensare la tecnica e di cogliere il senso pienamente umano del fare dell’uomo, nell’orizzonte di senso della persona presa nella globalità del suo essere. Anche quando opera mediante un satellite o un impulso elettronico a distanza”

Pensiamo al recente uso delle armi dotate di IA nei conflitti in Medio Oriente–il suo agire rimane sempre umano, espressione di libertà responsabile. C’è un grande dibattito: chi è responsabile?

Il dibattito odierno sul ruolo e la responsabilità delle grandi aziende dei social media è più acceso che mai. Queste aziende si riparano dietro alla famosa legge Section 230 degli Stati Uniti, che esonera piattaforme come Facebook o Google dalla responsabilità per i contenuti pubblicati dai loro utenti. Ma se questa protezione non esistesse, sarebbero altrettanto pronte a lanciare sul mercato algoritmi potenzialmente pericolosi con tanta leggerezza?

Fascino della tecnologia e responsabilità morale

La tecnologia esercita un forte fascino sull’uomo, liberandolo dalle limitazioni fisiche e ampliando i suoi orizzonti, come sottolineato anche nella Caritas in Veritate. Tuttavia, la vera libertà umana si manifesta pienamente solo quando si risponde al fascino della tecnologia con decisioni che riflettono una profonda responsabilità morale.

“La tecnica attrae fortemente l’uomo, perché lo sottrae alle limitazioni fisiche e ne allarga l’orizzonte. Ma la libertà umana è propriamente se stessa solo quando risponde al fascino della tecnica con decisioni che siano frutto di responsabilità morale. Di qui, l’urgenza di una formazione alla responsabilità etica nell’uso della tecnica. A partire dal fascino che la tecnica esercita sull’essere umano, si deve recuperare il senso vero della libertà, che non consiste nell’ebbrezza di una totale autonomia, ma nella risposta all’appello dell’essere, a cominciare dall’essere che siamo noi stessi”.

Se ci fermiamo a riflettere sulla concezione che abbiamo di noi stessi, possiamo notare come la dignità della persona umana sia sempre più messa in discussione. Un esempio palpabile di questo fenomeno si trova anche in un ambito tacitamente accettato da tutti: il fatto che ormai leggiamo le notizie solo su media dove sono automaticamente generate e suggerite dagli algoritmi. A mio avviso, la dignità umana si riduce quando diventiamo meri oggetti di scambio commerciale tra inserzionisti e piattaforme di social media, dove noi stessi siamo il prodotto. La nostra attenzione diventa semplicemente un ingranaggio da attivare per generare profitto.

La dignità umana

Che dignità può avere una persona se è considerata solo come parte di un meccanismo? Anche il lavoro umano, d’altra parte, è sempre più ridotto a un puro automatismo. Parlando frequentemente nelle scuole, osservo insegnanti che si interrogano su come rispondere all’impetuosa ondata di tecnologie, in particolare sul loro ruolo nell’educazione e nell’insegnare ai giovani come utilizzarle. Gli insegnanti stessi devono essere formati per comprendere queste tecnologie. Tuttavia, l’insegnamento, essendo una disciplina profondamente umana e basata sulla relazione interpersonale, rischia di perdere la sua essenza se ridotto a mero dispensare di regole burocratiche in processi predefiniti, “ingegnerizzati.”

In passato, abbiamo meccanizzato la professione insegnante; ora non dobbiamo stupirci se le macchine riescono a svolgere il lavoro in modo più efficiente o meno costoso. Il problema, però, è più profondo e risiede nelle decisioni che prendiamo su quali aspetti della nostra vita siamo disposti a trasformare in un involucro robotico in cui l’automazione può prosperare.

Non possiamo essere vittime dell’intelligenza artificiale

Dobbiamo riflettere attentamente su queste scelte. Non possiamo permetterci di essere vittime, come è accaduto con lo sviluppo dei social media, che hanno promosso la convenienza e l’immediatezza, per poi scoprire, anni dopo, che abbiamo contribuito ad aumentare i tassi di depressione e suicidio tra gli adolescenti. Ora dobbiamo chiederci: come possiamo uscire da questa situazione?

Qual è il nostro compito? Abbiamo già discusso dell’importanza dell’educazione, ma dobbiamo chiederci: educare a cosa? Direi innanzitutto alla libertà, cercando di promuovere, nelle scuole e nei luoghi sociali, un contesto in cui la vera relazionalità non sia solo online. Dobbiamo educare e lasciare spazio a tre dimensioni fondamentali dell’essere umano: libertà, relazionalità e trascendenza. Un essere umano che viene ridotto a meno di questi tre pilastri essenziali finisce per essere sfruttato meccanicamente dalle tecnologie. Nel messaggio del Dicastero per la Dottrina della Fede intitolato Dignitas Infinita (2024) si afferma:

“Sebbene ora esista un consenso piuttosto generale sull’importanza ed anche sulla portata normativa della dignità e del valore unico e trascendente di ogni essere umano,[14] l’espressione “dignità della persona umana” rischia sovente di prestarsi a molti significati e dunque a possibili equivoci[15] e «contraddizioni che inducono a chiederci se davvero l’eguale dignità di tutti gli esseri umani […] sia riconosciuta, rispettata, protetta e promossa in ogni circostanza». […] Il senso più importante è quello legato alla dignità ontologica che compete alla persona in quanto tale per il solo fatto di esistere e di essere voluta, creata e amata da Dio. Questa dignità non può mai essere cancellata e resta valida al di là di ogni circostanza in cui i singoli possano venirsi a trovare”.

Educare a chi è l’uomo

È fondamentale comprendere chi sia realmente la persona umana quando si prendono decisioni su come adottare, utilizzare ed educare all’uso delle tecnologie. Quando parliamo di educare una persona, dobbiamo prima di tutto avere una chiara definizione di cosa significhi “persona”. Concludo con un aneddoto che ho trovato sia interessante che simpatico, e che ho avuto l’opportunità di osservare proprio oggi.

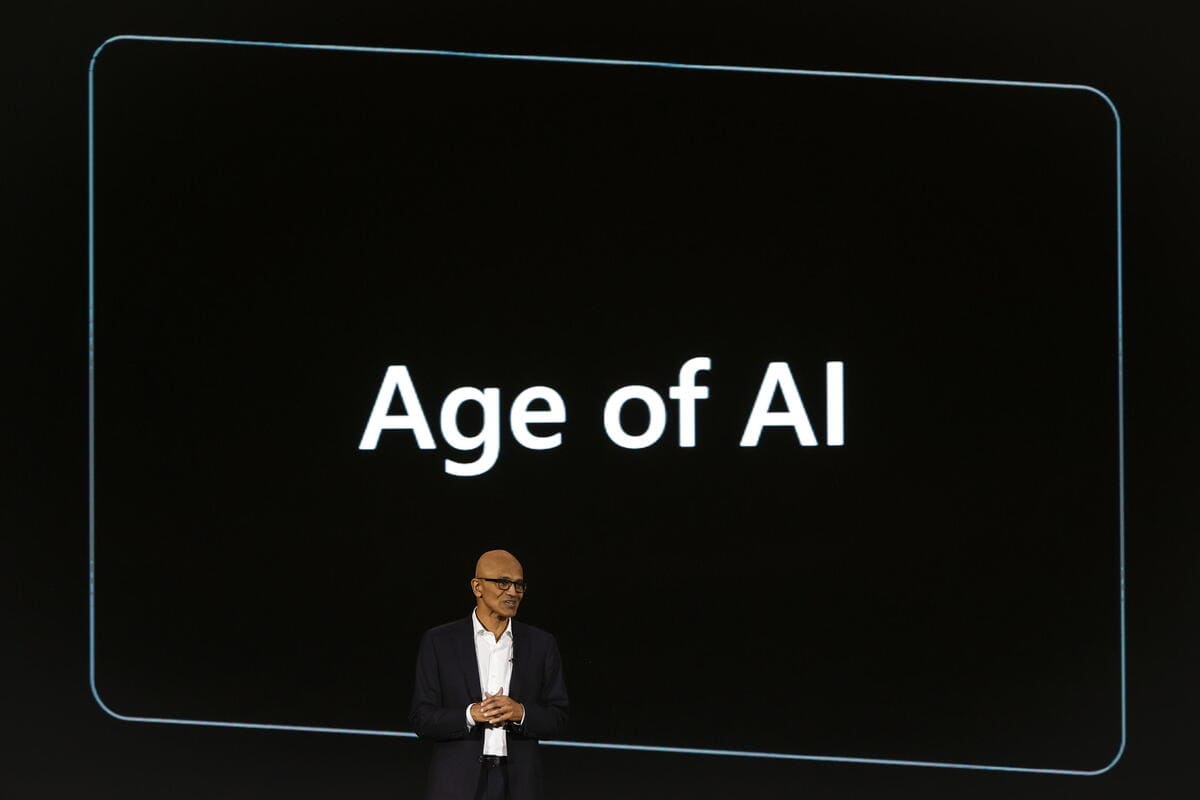

Di recente, durante la famosa conferenza TED in America, tra i relatori c’erano numerosi esponenti del mondo dell’intelligenza artificiale. Uno di questi, che trovo particolarmente interessante, è Mustafa Suleyman, cofondatore di DeepMind, ora parte di Google sotto il nome di Google DeepMind. Recentemente, Suleyman ha fondato un’altra compagnia che lavora su modelli linguistici simili a ChatGPT e ora è stato assunto da Microsoft per guidare una nuova divisione focalizzata sullo sviluppo dell’IA.

Suleyman è stato tra i primi, nel 2010, a parlare di AGI (Artificial General Intelligence) e del sogno di creare una “intelligenza generale artificiale”. Tuttavia, nel suo libro pubblicato l’anno scorso, “The Coming Wave” (“L’onda che sta arrivando”), si distacca dal termine AGI e introduce il concetto di “artificial capable intelligence”, dove l’accento è posto su una tecnologia sempre più capace di prendere decisioni e svolgere compiti che in precedenza non erano delegati a computer o tecnologie.

Nel suo discorso TED, Suleyman enfatizza la necessità di definire con precisione il linguaggio e le metafore utilizzate quando si parla di IA. Sottolinea che confondere le persone facendole pensare che si stia creando una super intelligenza destinata a distruggere il mondo non è utile. Lui usa la metafora di “introdurre una nuova specie digitale” per descrivere l’avanzamento dell’Ai, sottolineando così l’importanza di un approccio chiaro e responsabile nel discutere di queste tecnologie.

L’intelligenza artificiale è un’estensione di tutti noi

In un certo senso, l’intelligenza artificiale è un’estensione di tutti noi – «AI is all of us», dice Suleyman. Ad esempio, GPT è stato addestrato su tutto il sapere umano pubblicato su internet, rappresentando così, in qualche modo, una sintesi dell’umanità. Questo aspetto può risultare ironico, considerando che a volte questa rappresentazione è letteralmente vera. Un recente scandalo ha rivelato che il sistema di automatic checkout di Amazon nei supermercati non si basava su un’intelligenza artificiale avanzata, ma su un esercito di lavoratori indiani sottopagati impegnati nel labeling in tempo reale dei prodotti scansionati dalle telecamere dei supermercati di Amazon. In quel caso, l’Ai era, effettivamente, un gruppo di persone!

Tuttavia, tornando all’idea di Suleyman, la metafora di “introdurre una nuova specie digitale” rimane intrigante e affascinante, pur con i suoi limiti. Se prendiamo sul serio questa metafora, siamo costretti a riflettere profondamente su questioni fondamentali: cos’è l’Ai? Siamo noi, “all of us.” Dunque chi siamo noi? Che cosa è l’essere umano? Le risposte a queste domande influenzeranno il tipo di intelligenza artificiale che sviluppiamo.

0 commenti

Non ci sono ancora commenti.

I commenti sono aperti solo per gli utenti registrati. Abbonati subito per commentare!