Contenuto riservato agli abbonati

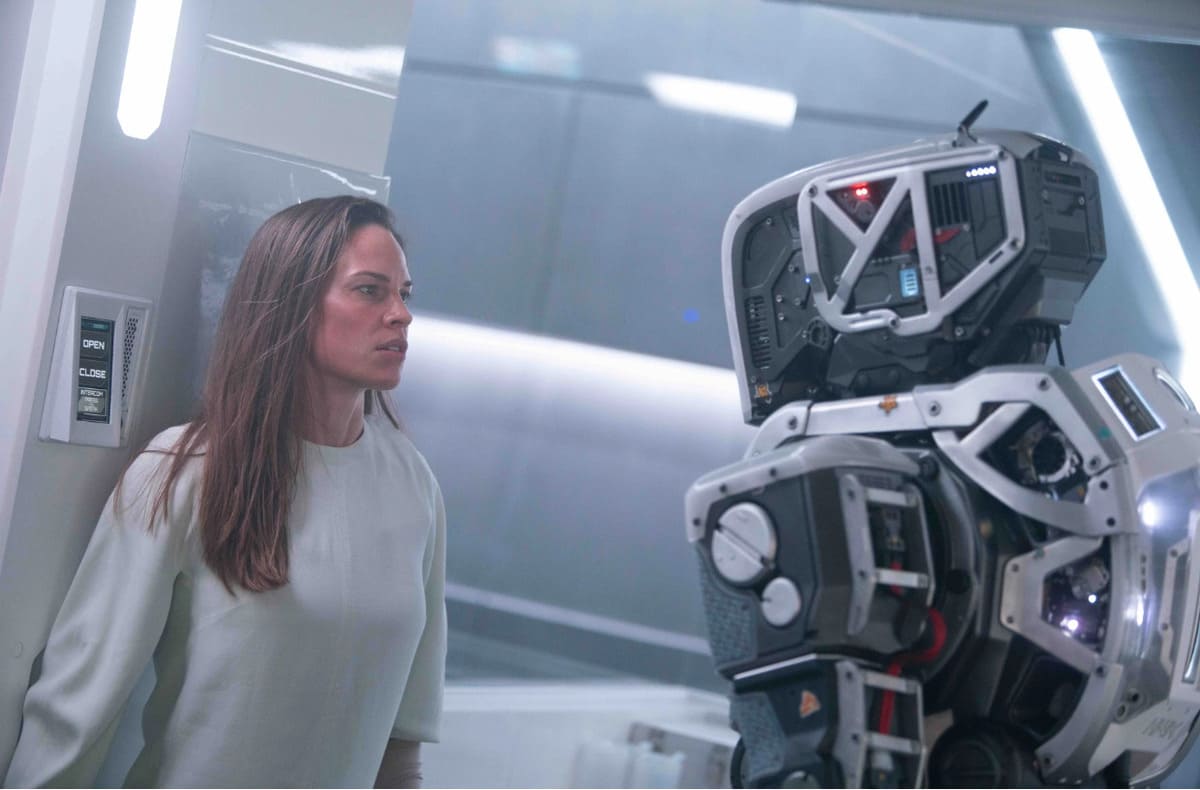

Dopo il manifesto firmato da oltre 1.000 esperti e ricercatori che chiedevano una pausa di sei mesi nello sviluppo dell’intelligenza artificiale, ieri un gruppo di leader del settore ha pubblicato una lettera aperta in cui sostiene che la tecnologia di Ai che stanno costruendo potrebbe un giorno rappresentare una minaccia esistenziale per l'umanità e dovrebbe essere considerata un rischio sociale alla pari delle pandemie e delle guerre nucleari. Gli oltre 350 dirigenti, ricercatori e ingegneri firmatari della dichiarazione pubblicata dalla organizzazione senza scopo di lucro Center for AI Safety parlano addirittura di «rischio di estinzione» da mitigare, cosa che «dovrebbe essere una priorità globale insieme ad altri rischi, come le pandemie e la guerra nucleare».

Mitigare i rischi dell'intelligenza artificiale

A lanciare l’allarme, che resta però vago e non spiega di quali rischi stia parlando, ci sono tra gli altri i ceo di tre delle principali società di intelligenza artificiale: S...

Contenuto a pagamento

Per continuare a leggere accedi o abbonati

Abbonamento full

€60 / anno

oppure

Abbonamento digitale

€40 / anno